Gemini 2.0: Google випустила низку ШІ-оновлень

- Google випустила нову модель Gemini 2.0, яка потужніша за попередню та оснащена функціями мультимодальності.

- В оновлену версію додано інструмент Deep Research для міркувань.

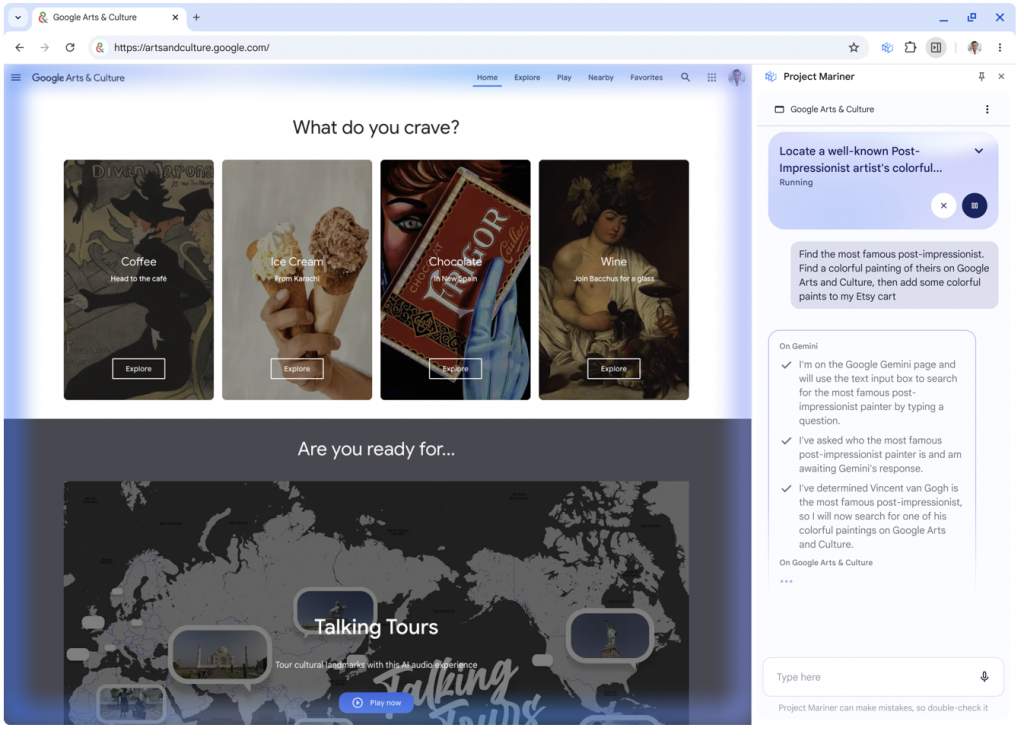

- Додатково представлений ШІ-агент Project Mariner — він здатний виконувати дії на комп’ютері замість користувача.

- Google анонсувала поліпшення системи зведень пошукових запитів AI Overviews.

11 грудня Google представила «свою найпотужнішу на сьогодні» модель штучного інтелекту — Gemini 2.0.

Welcome to the world, Gemini 2.0 ✨ our most capable AI model yet.

— Google DeepMind (@GoogleDeepMind) December 11, 2024

We're first releasing an experimental version of 2.0 Flash ⚡ It has better performance, new multimodal output, @Google tool use – and paves the way for new agentic experiences. 🧵 https://t.co/ywY2oZv76p pic.twitter.com/1Wgcr3m2Ip

Спочатку запущено експериментальну версію 2.0 Flash, яка має високу продуктивність, функції мультимодальності та «прокладає шлях для нового агентського досвіду».

Gemini 2.0 Flash перевершує 1.5 Pro за ключовими метриками, демонструючи подвоєну швидкість. Вона здатна генерувати зображення, текст і мову кількома мовами. Повідомляється, що модель значно поліпшена в галузях програмування та аналізу картинок.

2.0 Flash стає флагманською нейромережею замість 1.5 Pro. Нова нейромережа може використовувати сторонні додатки та сервіси на кшталт пошуку Google і зовнішніх API, що відрізняє її від попереднього покоління.

As our workhorse model, Gemini 2.0 Flash outperforms 1.5 Pro on key benchmarks, at twice the speed.

— Google DeepMind (@GoogleDeepMind) December 11, 2024

It can generate images mixed with text as well as customizable text-to-speech multilingual audio. 2.0 Flash can also call tools like @Google Search, code execution and third-party… pic.twitter.com/OVicGFnJdP

Gemini 2.0 Flash доступна в чат-версії для всіх охочих, експериментальна мультимодальна нейромережа з функціями перетворення тексту на мовлення і зображення — для розробників через Gemini API в Google AI Studio і Vertex AI. Найближчими місяцями поліпшена версія ШІ плавно пошириться на різні продукти на кшталт Android Studio, Chrome DevTools, Firebase, Gemini Code Assist та інші.

ШІ-агент Google

ШІ-підрозділ Google — DeepMind — представив свого першого ШІ-агента, який здатний самостійно діяти в інтернеті.

Project Mariner створений на базі Gemini 2.0 і доступний обмеженій групі тестувальників. Він контролює браузер Chrome, переміщує курсор на екрані, натискає на кнопки, заповнює форми, тобто здатний переміщатися вебсайтами та поводитися як людина.

Після налаштування ШІ-агента праворуч у браузері з’являється вікно чату. Там можна задати інструкції нейромережі, наприклад, запропонувати створити кошик покупок із продуктового магазину на основі прикріпленого списку.

Після зазначення всіх параметрів агент перейде на вебсайт супермаркету, знайде потрібні товари та додасть у віртуальний кошик. Швидкість його роботи повільна — на натискання однієї кнопки йде близько п’яти секунд.

Project Mariner не здатний заповнити номери кредитних карток та іншу платіжну інформацію, приймати файли cookie і підписувати угоди з надання послуг. Це зроблено навмисно, щоб у користувачів залишалося більше контролю.

Агент може використовуватися для пошуку рейсів, готелів, рецептів, купівлі предметів та інших завдань. Під час виконання запиту користуватися комп’ютером не можна.

Project Mariner поки недоступний широкому загалу, дата його публічного релізу невідома.

Інші ШІ-агенти

Крім Project Mariner корпорація Google представила низку інших ШІ-агентів для більш вузькоспеціалізованих завдань:

- Deep Research здатний допомогти досліджувати складні теми, створюючи багатоетапні плани навчання. Він не призначений для вирішення математичних і логічних завдань, написання коду або аналізу даних;

- Jules може програмувати, він інтегрується в робочі процеси на GitHub, з’явиться у 2025 році;

- ще один ШІ орієнтований на допомогу у відеоіграх, дата його випуску невідома.

Gemini навчили міркувати

Оновлена версія Gemini отримала функцію Deep Research, яка використовує «просунуті міркування» і «можливості довгого контексту» для створення короткого витягу про дослідження. Брифи можна експортувати в Google Docs для додаткового редагування.

The new Deep Research feature from Google feels like one of the most appropriately "Google-y" uses of AI to date, and is quite impressive.

— Ethan Mollick (@emollick) December 11, 2024

I've had access for a bit and it does very good initial reports on almost any topic. The paywalls around academic sources puts some limits. pic.twitter.com/dwSqr6aKGZ

Сервіс може аналізувати інформацію щодо запиту за допомогою інтернету, виступаючи в ролі свого роду наукового співробітника. Результат роздумів подається у вигляді короткого резюме з посиланнями на джерела. Процедура наступна:

- Користувач пише запит.

- Deep Research створює «багатоетапний план дослідження».

- Користувач підтверджує старт аналізу.

- Deep Research проводить дослідження протягом кількох хвилин і генерує відповідь.

Сервіс доступний для власників платної версії Gemini Advanced.

AI Overviews стане розумним і мультимодальним

Google анонсувала поліпшення системи зведень пошукових запитів AI Overviews. Повідомляється, що сервіс незабаром зможе обробляти «складніші теми», «мультимодальні» і «багатоетапні» пошуки, зокрема розширені математичні запити та завдання програмування.

Тестування функціоналу розпочнеться цього тижня, а широке поширення — на початку наступного року.

Поліпшення AI Overviews зумовлене запуском Gemini 2.0.

Нагадаємо, у листопаді Google навчила чат-бот Gemini запам’ятовувати контекстну інформацію про життя користувача, його інтереси та вподобання.