ШІ навчили передбачати рух за візуальними даними мозку

Дослідники Університету Кобе розробили ШІ-алгоритм, що вгадує дії миші, ґрунтуючись на даних візуалізації мозку.

Вчені досягли успіхів у декодуванні нейронної активності, що прискорить розвиток BCI (інтерфейс «мозок-машина»). Використовуючи ШІ-алгоритм розпізнавання зображень, команда передбачила рух миші з точністю в 95%.

«Наш досвід роботи з системами візуалізації та відстеження руху мишей на основі VR і глибокого навчання дав змогу використовувати „наскрізні методи“. Вони не потребують попереднього опрацювання й оцінюють інформацію по всій корі головного мозку для декодування практично в реальному часі», — повідомив керівник проєкту Такехіро Адзіока.

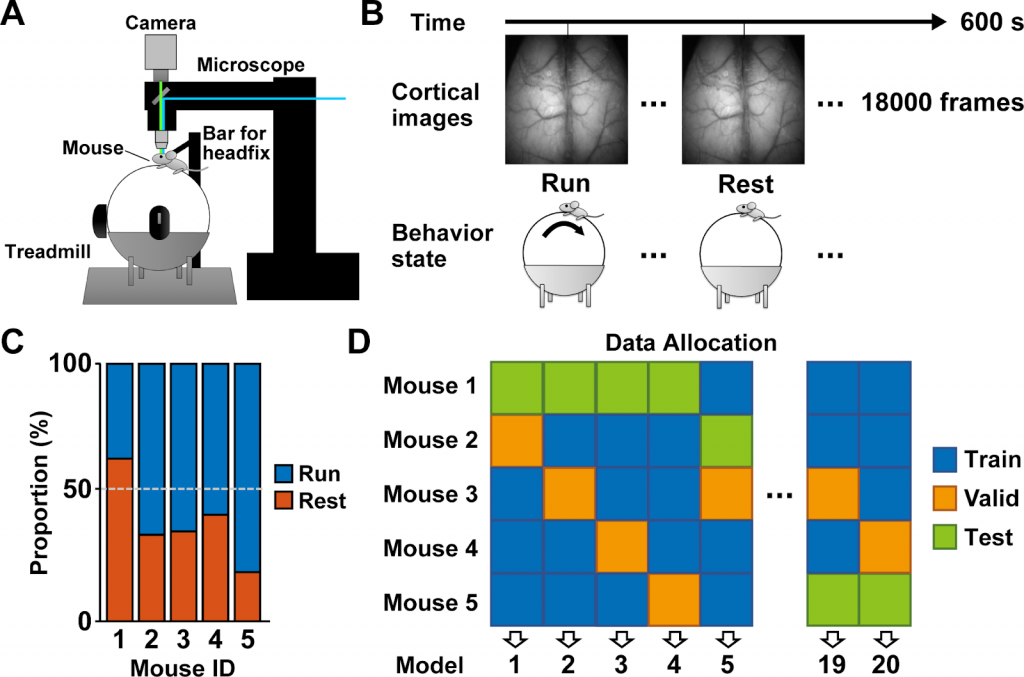

Інноваційний підхід об’єднав два алгоритми глибокого навчання — для аналізу просторових і часових патернів. Дослідники застосували їх до візуальних даних мозку мишей, які перебувають у стані спокою і руху біговою доріжкою. Потім ШІ-модель навчили прогнозування дій тварини.

Точність досягла 95% без необхідності видалення шуму. Для декодування потрібно всього 0,17 секунди даних, що свідчить про здатність моделі здійснювати передбачення в режимі реального часу.

Ще однією відмінною рисою цього дослідження є його застосовність до кількох піддослідних мишей. Така універсальність дає змогу ШІ-моделі ефективно відсіювати індивідуальні відмінності в структурі та функціях мозку, фокусуючись виключно на сигналах, які вказують на рух або спокій.

Ця особливість підкреслює потенціал адаптації технології для ширшого і різноманітнішого застосування, зокрема на людях.

Нагадаємо, в лютому вчені з Теннесі навчили нейромережу аналізувати мозкову активність мишей і повідомляти, де перебуває тварина і в який бік вона дивиться.